1866年,西门子的一位工程师发明了人类第一台直流发电机。

40年后,通用电气在1906年开始量产真正让电灯普及的第一代白炽灯泡。

在这两者之间的半个世纪里,人类世界依然黑暗,电气的技术革命好像没有发生。

但,这只是因为我们身处后世,才能如此轻描淡写地将这40年一笔带过。

对于当时的人们来说,电气技术的发展,是他们眼皮底下一天天展开的:第一条电报线路的铺设,第一个电话的接通,第一辆电车的开动,每一次技术的进步,都在真切地改变着他们的生活,只是它没有快到让当时的每个人都在一个时间点集体惊呼“啊,电气革命终于来了!”

我们此刻正站在一个与19世纪末极为相似的节点上。AI技术的“直流发电机”已经轰鸣作响,只能发光十几个小时的“碳质灯丝”也已点亮,新的光明时代正在徐徐展开。然而,当我们身处其中时,却发现这场变革似乎并没有想象中那般迅猛,甚至有些迟缓。

在经历了2022年末ChatGPT横空出世带来的震撼,2023年大量AI“玩具级产品”的轰炸之后,2024年的AI领域显得有些“波澜不惊”。让我们以OpenAI在12月的12场发布会为线索梳理一下:

1. Sora犹抱琵琶半遮面,千呼万唤跳票了一整年,出来的效果虽然是“同类最佳”,但很难说能有什么实际用处;

2. GPT-5跳票,被寄予厚望的GPT-o1满血版和暂时不能用的o3在价格和可用性(资料输入、联网、推理速度)都存在严重缺陷。

3. ChatGPT Canvas、ChatGPT高级语音模式、Projects功能要么是早就PPT发布过的功能实装,要么是同行有的功能终于补齐。

除此之外涵盖推理模型API、微调技术、协作模式等还发了一大堆,乍一看令人眼花缭乱。但细细品来,却总觉得少了点当初那种“革命性”的味道,更像是在已有成果上的修修补补。

如今再看OpenAI的发布会,甚至有种在看苹果发布会的既视感——挤牙膏式升级。我觉得看完这12场发布会,还指望o3突破所谓AGI的人,和去年那些坚信Apple Vision Pro能带我们跑步进入元宇宙的人一样。我只能祝他们和Sam Altman幸福。

更多的人们反而是开始窃窃私语——说好的AI革命呢?说好的技术大爆炸呢?怎么感觉这AI的发展速度,和前两年比起来,慢了不少呢?甚至有人开始质疑:难道说,Scaling Law已经失效了吗?

Scaling Law失效了吗?要回答这个问题,我们得先简单科普一下Scaling Law。

Scaling Law,简单来说,就是“大力出奇迹”——只要不断增加模型的参数量和训练数据的规模,AI模型的性能就能持续提升。这一规律在过去几年里,推动了AI领域的高歌猛进,让我们见证了AI能力的飞速增长。如果说2022年初的ChatGPT还能让人觉得“这玩意儿挺新鲜”,那2022年末诞生的ChatGPT已经可以让人惊呼“卧槽,这玩意儿成精了!”——而这背后,正是Scaling Law在发挥作用。

然而,随着AI技术的不断发展,一个问题逐渐浮现:当模型的参数量越来越大,训练数据越来越多时,我们还能看到同样显著的性能提升吗?一些研究表明,简单地增加规模已经不能再带来线性甚至指数级的进步了。模型变得更大,但边际效益在逐渐递减。

2024年11月,在海外媒体报道GPT-5训练遇到障碍后,Sam Altman发的X

这个问题对AI行业来说真的非常重要,甚至OpenAI的12场发布会本身就是对这种质疑的一个回应。虽然以我的视角来看,这个回应某种程度上证实了Scaling Law撞墙。

然而,Scaling Law撞墙与否又和非AI行业有什么关系呢?

关系就是,如果AI技术撞墙了,那么我们普通人和非AI企业的AI革命就更快了。

在技术发展的历程中,我们常常会看到这样一种现象:当一项技术在取得突破性进展后,有时会在一段时间内进入一个相对平稳的发展期。这并不是说这项技术停止了发展,而是说它正在从“质变”重新走回“量变”,从追求技术的进一步突破,转到如何将已有的技术应用到真正有价值的事情上。

可以设想一下:当一项新技术出现时,行业和资本往往会先关注它本身的能力,比如我们会关注AI是不是更聪明了,是不是能够处理更复杂的任务了,哪些公司的模型最有优势,能为投资带来超额回报。

这就像是王者开局的“打野”阶段,没人会将注意力放在开团上。但是,随着技术的逐渐成熟,业界的关注点会逐渐从技术本身转向技术的应用,大家开始思考如何将AI技术与实际的应用场景相结合,如何利用AI来解决实际的问题。毕竟,到目前为止我们还是人类社会,一项技术必须要有用,要争夺“人类”市场,才能真正获得回报。这就进入了“推塔”阶段,目标变成了如何将技术优势转化为实际的生产力。

当前AI领域的情况正是如此。一方面,我们看到AI技术本身的发展似乎有所放缓,大模型参数的增长速度、算力的提升都面临瓶颈。过去那种“每隔几个月就有一个重大突破”的景象似乎难以再现。但是另一方面,更稳定的模型参数和持续下降的价格,能吸引更多的开发者和企业将AI引入到自己的应用之中。

这对于普通人和非AI企业来说,是一件好事,毕竟普通用户每天在用的不是AI的模型,甚至连API都不是,而是使用了API的应用产品。

而当技术的发展不再是唯一的核心命题,当“大力出奇迹”不再是性价比最高的选择,整个行业的目光自然会转向应用的探索。这时候,才是AI真正与各行各业深度融合的开始,才是ai应用百花齐放的时代。

我在《评论尸的AI生产力经验》中曾经给小白用户科普过,AI在实际应用中的能力等于模型能力和非AI的工程能力相加。但在应用过程中,模型的变动,甚至是“进化”经常会影响工程的构建。

你千辛万苦搭建了一个AI应用/工作流,可能会被一次模型的更新全部摧毁,这是普通用户难以理解,但实际可能出现的事情。

这也是为什么,在开发者圈子里,Anthropic年中上线的Claude 3.5系列模型和Google为了对抗OpenAI在12月发的一系列Gemini 2.0系列模型反而更让业界的人更兴奋。因为这两个公司的产品没什么特别大的突破,也不搞什么花活,就是在已知的道路上继续做到量大(上下文)管饱(价格)。

更何况,在生产力经验那篇文章中,我提过另一个关键问题:大部分人和企业对当前能力水平的AI还挖掘不足,因为他们在工程化的方向上能力为零,以至于“现在的AI也就这样”。但实际上,他们低估了现在AI的能力,并且错误地预期了更好的AI能力能让他们觉得不可能的那些事情变可能(比如一周编个淘宝)。

这种认知的错误,让大众误以为Scaling Law撞墙会终结这次AI革命给社会的影响,但实际上恰恰相反。许多人觉得AI的潜力已经到头了,是因为他们的数字素养还不足以充分利用现有的AI工具。换句话说,这是连手头的“铁锹”还没用明白呢,就已经在担忧“金矿”挖空了。

我们可以用一个不那么恰当,但很形象的例子来说明这个问题:

有人可能以为,在互联网时代,技术在实验室层面的革命会更快地推送到市场,但现实是并不一定。比如,如果你最近在中国的大江南北体验过移动支付,应该会发现微信支付和支付宝正在进行新一轮的鏖战。

前者推出了掌纹支付,你只要绑定一次你的手掌,以后即便是在没有手机的情况下也可以用微信支付。掌纹识别是一项新的技术吗?嘿,这可真是撞我枪口了。2013年刚毕业的我,在一家FA工作,当时对接的一个叫PalmVisa的初创公司就是做掌纹识别的。按照当时创始人的说法,掌纹识别在当时就达到了金融支付凭证等级的安全性,而且它还没有指纹、虹膜泄露的问题。

但在这之后的10年里,掌纹识别这项技术几乎消失在商业领域,而微信之所以将它捡起来。是因为它的对家支付宝开始推碰一碰付款,也就是NFC支付。NFC这项技术熟悉的人就更多了,媒体上一次讨论“互联网与现实世界的超链接应该是NFC还是二维码”这个选题的时候还是2012年。

你看,在“金融支付”这么大的一个市场,掌纹识别和NFC这两种在技术上完全可行的方案,都要十年才能推动。这说明什么?说明应用领域要逼近技术的“天花板”需要时间和契机。

实际上,这样的例子屡见不鲜。

另一个比较典型的例子是,中小微企业的数字化。

在2015年,你很难相信随便一个餐馆都会做自己的独立App,但到了2018年,微信小程序如火如荼,随便一个路边摊都有自己的小程序,点餐、支付、会员、营销,一应俱全。

这并不是因为2018年的App开发技术比2015年有了质的飞跃。恰恰相反,是因为微信(和美团)这个超级平台已经形成,它为开发者提供了足够的基础设施、稳定的技术栈(不怎么更新的过时技术)和用户流量,使得开发小程序的成本足够低,收益足够高。

几乎所有做开发的人都会吐槽小程序,但实际上正是小程序在技术上的落后保障了它的普及性。毕竟,时至今日其实Android手机也没有解决系统碎片化的问题,大量的用户仍然使用着5年前的Android 10系统。iOS方面稍微好一点,但也没好到哪去。这意味着,对于主业不是做互联网产品的其他行业来说,如果需要再给用户一个数字化的入口,独立客户端无论如何都不是一个性价比高的选择。

基本上,只有平台型企业形成稳定的寡头垄断之后,才能为海量的微小企业和非IT相关行业提供稳定成长的土壤。想必很多今年做出海的也都意识到了,一些诸如支付网关、电商、社交网络、云、原生小程序(PWA)这样的基础设施型工具必然与平台型互联网公司密不可分。

平台型产品孕育生态,而平台型产品诞生于平台期。

比个体数字素养增长更慢的,是组织的企业素养。即便是在极度内卷的中国职场上,一家企业也不可能只招30岁以下的人,尤其是对于非IT行业的企业来说更是如此——许多传统行业的老板本身就不是年轻人,对非核心生产部分的技术并不敏感。

这就造成了,当京东和元气森林等一些新型企业在试图落地“无人工厂”这样的先进技术时,中国绝大多数的中小规模以下工厂还在用Excel(甚至是盗版)进行生产计划安排、库存管理以及排产调度等基础工作,显得颇为原始。

AI什么时候能影响到这些工厂呢?我觉得可能至少要等他们把Excel换成正经的ERP系统,或者正经的MES(制造执行系统)才行吧?

而老板和企业都是趋利的,想让一个组织进行非核心技术的迭代,要让他们看到足够的好处或收益。这里的核心技术是指与他们生产直接相关的技术,比如对可口可乐来说,配方就是核心技术,而生产线的自动化设备或者供应链管理系统则是支撑配方实现的非核心技术。

显然,对于非互联网企业来说,一个光秃秃的AI模型无论多聪明都带不来好处——很多人将OpenAI已经发布但尚不可用的o3称为“博士级模型”,但你可以去找个今年毕业的博士问问他们工作好不好找。

实际上,我们现实中的大部分工作并不需要博士级的智能,只需要高中级甚至是初中级。

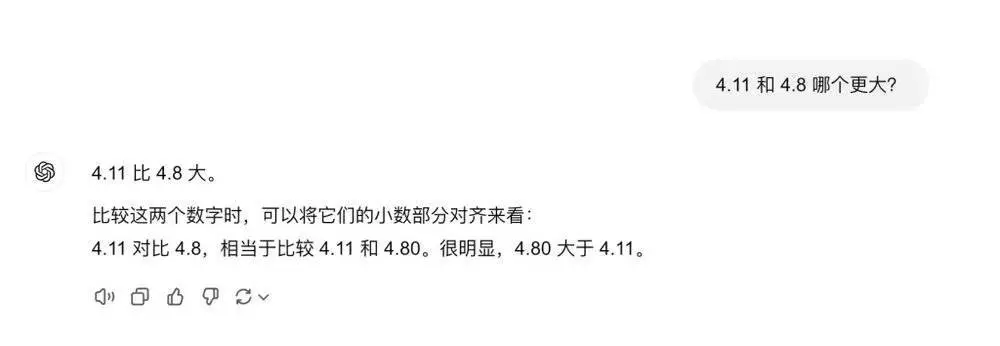

我今年听到的最好笑的证明AI不行的例子,就是很多人发现GPT-4o认为4.11比4.8大。但我想大家如果经常刷社交网络也都知道,这个世界上确实有很多真人也搞不定10以内加减法的,但这并不影响他们在工作岗位上发光发热,尤其是在欧美国家。

之前和一些机构型媒体的朋友交流,他们中的许多人认为当前AI对传媒业的影响不大,但同时他们又十分害怕未来GPT-5或其他公司的新模型如传闻中的那样颠覆他们的工作。然而,这是典型的错误认知带来的错误焦虑。

实际上,我之前分享过一个大致的流程。以现阶段AI的水平,它已经可以完全替代记者编辑,全自动完整撰写带有真实采访的人物特写稿件。

之所以这件事没有成为“现实”,或者说,大部分媒体朋友之所以感觉当下的AI对传媒业影响不大,并非是因为AI模型能力不行,而是因为这件事目前的价格优势没有大到有人愿意将这个Workflow完整的工程化出来做成产品。

如果这样带有真实采访的稿件生成器,可以将每篇万字长稿的生成成本降到300元以内,那么想必它立刻就会出现,甚至会迅速在自媒体平台上泛滥。

但这和模型能力的进一步提升关系不大,反而是需要AI厂商放一放对能力的执念,转而卷一卷价格。

甚至连大部分成熟的IT和互联网企业在接入AI这件事上也正处在一种“等待”的状态,正如我在《不要轻易地走进AI Native(AI原生)》提到的:对于大多数我们现在已经熟知的,熟悉的产品来说,AI并不能成为决定性的用户需求。用户并不可能因为一个AI功能而放弃那些在传统功能和网络效应上有极大优势的产品。

那么,反过来说,那些看起来笨重的老牌互联网企业,也就有更多的时间进行转型。他们有足够的时间等待AI更加稳定,无论是在输出的内容上、性能上、安全性上、价格上等等,而不是每月要发一个新版本来适应AI进步的速度。用一个最简单的道理来说明:

如果你是一个拥有自建IDC的传统互联网大厂,现在想引入一款开源模型来实现产品中的某个AI功能。现在开源模型的推理成本每个月季度降30%,这看起来是一件好事,但这意味着你在服务同样用户量的情况下,第一个季度买的1万张显卡,第二个季度就只需要7000张显卡。那么,你第二个月闲下来的3000张显卡做什么?

明智的选择,当然是让用户忍一忍,或选个已经停滞的模型,浅尝辄止的先糊弄一下。因为你知道,AI底层的进化速度根本不可能持续,等它撞墙了你再给它搭配套应用也不迟。

当AI技术的发展进入一个相对稳定的阶段,当大模型的能力不再是稀缺资源,当AI基础设施逐渐完善,我们会看到企业和资本会将更多的注意力转入让AI进入应用领域,与越来越多人工作和生活中的具体场景结合。它会在一些场景成功,而在另一些场景失败,而这些都和撞墙或没撞墙的Scaling Law没有关系。

因为大多数人、企业、组织,甚至连GPT-3.5级别的人工智能都还没能完美的嵌合到现有的工作流中。那么着急的唱衰AI或擅自期待GPT-5又有什么用呢?

所以,除非你是做基础大模型的,否则别再纠结Scaling Law是不是失效了,也别再抱怨AI的发展速度变慢了。

对于大多数人来说的AI变革才刚刚开始。

.png)

发评论,每天都得现金奖励!超多礼品等你来拿

登录 在评论区留言并审核通过后,即可获得现金奖励,奖励规则可见: 查看奖励规则